在 Zeabur 上一键部署 Dify:零门槛构建 LLM 应用

告别繁琐的后端开发。本文教你如何利用 Zeabur 快速部署 Dify,几分钟内搭建并扩展生产级 AI Agent 和 RAG 工作流。

前言

GPT-4 的发布以及随后大型语言模型(LLM)的爆发式增长,引发了各界对 AI Agent(智能代理)的新一轮想象。每一位开发者、产品经理和技术负责人(CTO)似乎都立刻意识到了它的潜力:利用这些智能代理来实现客服自动化、智能搜索等功能。

但随着最初的兴奋感消退,"落地之墙"出现了。当你拥有了模型,但该如何围绕它构建一个安全、可靠的应用程序?如何让它理解你的业务?如何防止它胡说八道?

我们的解决方案之一就是 Dify.ai。

什么是 Dify?

从核心来说,Dify(即 Define + It + For + You)是一个专为 LLM 应用开发量身打造的开源平台。它通过整合两个关键概念,解决了现代 AI 开发中的碎片化问题:

-

后端即服务(Backend as a Service, BaaS): 它包揽了所有繁重的工作——无需担心数据库管理、API 生成,甚至服务器逻辑——所以如果你是前端开发者,真的可以做到"即插即用"。

-

LLMOps(大型语言模型运维): 它提供了一整套工具来监控、管理并随着时间优化你的 AI 模型性能。

Dify 是一个统一的平台,让各类开发者都能快速打造出生产级的生成式 AI 应用。

技术架构:技术栈

Dify 是一套全面的 AI 工具库,旨在让你免于"重复造轮子"。

- 模型无关: Dify 确保你不会被单一供应商绑定。它支持数百种模型(OpenAI、Anthropic Claude、通过 Ollama 运行的 Llama 等)。你只需点击

一下即可切换模型,以平衡成本与性能。

-

提示词编排: 一个可视化的"工作台"让你可以调整提示词并实时查看结果。这让"提示工程"变得对整个团队都触手可及。

-

灵活的 Agent 框架: 除了简单的对话,Dify 还允许你构建能做事的 Agent——将复杂的目标拆解为步骤并自动执行任务。

-

即时 API 生成: 当你在 UI 中设计好应用程序的那一刻,Dify 就会为其生成标准的 API。你的前端团队可以立即开始集成。

为什么要用 Dify?四大理由:用 Dify 的工具库解决难题

如果你曾经尝试使用原始 API 或复杂的库从头构建一个定制 AI 应用,你很可能已经碰到了一些障碍。但有了 Dify,你再也不用担心这些问题。

1. "我该如何用自己的数据'训练'模型?"

问题: 公共模型(像标准的 ChatGPT)不了解你公司的内部 Wiki、PDF 文档或客户支持记录。

Dify 的解决方案: 其实你不需要"训练"(那既昂贵又缓慢)。Dify 提供高质量的 RAG(检索增强生成)引擎。你只需提供必要的数据,Dify 会处理剩下的工作(分段、索引和向量化)。它将你的静态文件转化为 AI 的可搜索知识库。

2. "如何设置那些复杂的工作流?"

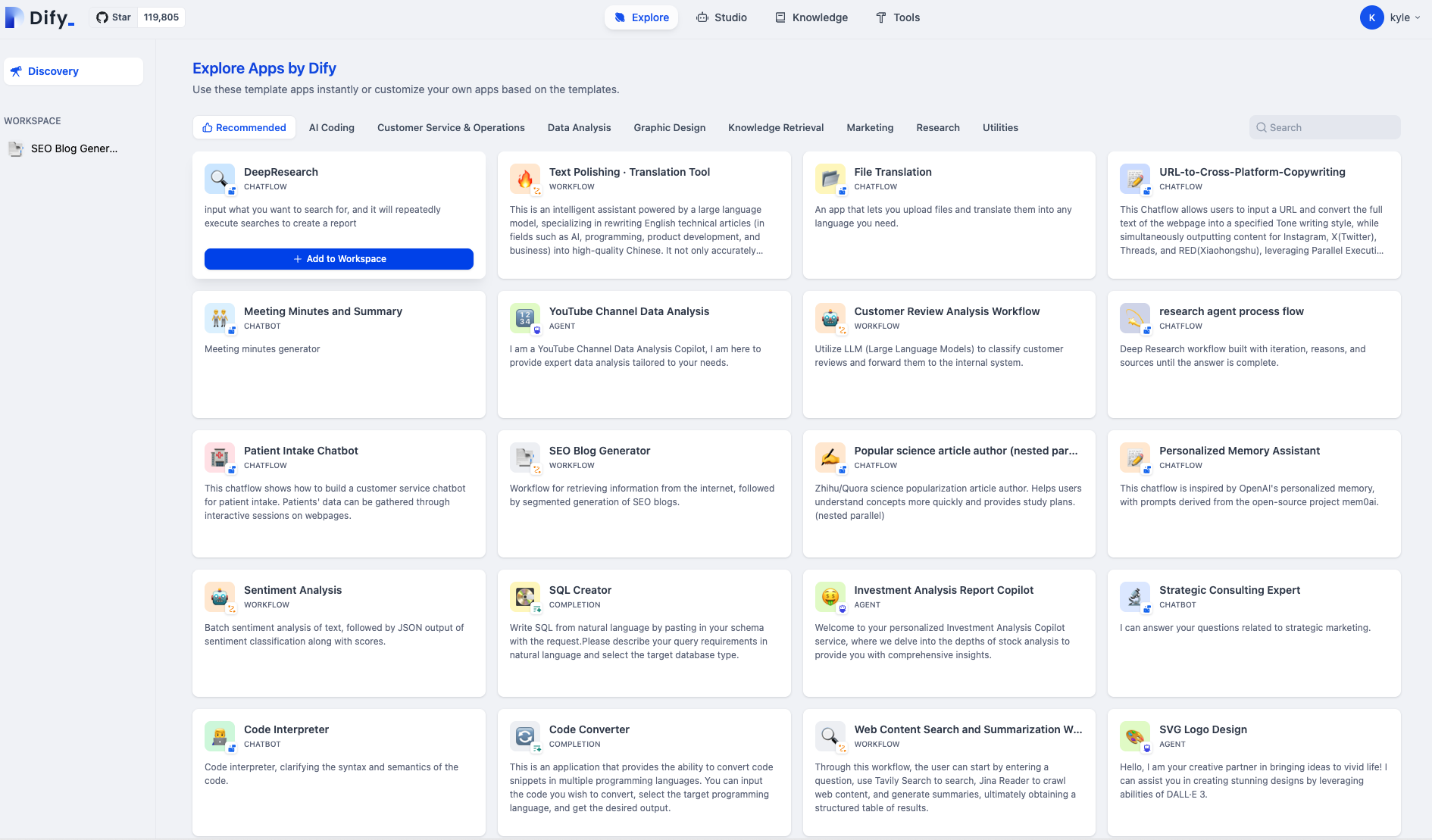

问题: 如果你是 n8n 的新手,你可能搞不懂如何构建工作流,但别担心,Dify 已经准备好许多经过其他用户测试的实用工作流。

Dify 的解决方案: 你可以前往 Dify 的探索页面,那里有许多已经构建并测试过的顶级工作流,就像 Zeabur 一样,点击一下,一切就绪。

Dify 的探索工作流页面

3. "我该如何防止 AI 说谎(幻觉)?"

问题: LLM 有时会变成充满自信的骗子。如果它们不知道答案,它们通常会编造一个。

Dify 的解决方案: 通过上述的 RAG 功能,Dify 严格地限制了模型。你可以配置系统仅根据你的知识库中提供的上下文来回答,大幅减少错误信息,确保 AI 在你的特定领域表现得像个专家。

4. "我是前端开发者...我真的必须写一个 Python 后端吗?"

问题: 要构建一个安全的生成式 AI 应用,你通常需要一个 Python 后端(使用 LangChain 或 LlamaIndex)来管理 API 密钥、上下文和向量数

据库。对于前端开发者或产品经理来说,这种基础设施的负担是一个巨大的入门门槛。

Dify 的解决方案: Dify 充当 BaaS(后端即服务) 的角色。当你在 Dify UI 中配置好 Agent 的那一刻,它会自动为该 Agent 生成一个安全、可直接用于生产环境的 API。你的前端团队只需调用这个 API 来发送消息并接收答案,完全跳过了构建和维护定制后端服务器的需求。

战略优势:隐私与控制权

虽然像 OpenAI 的 "Assistants API" 或定制 "GPTs" 很强大,但它们通常要求将你的数据发送到一个"黑盒"生态系统中。

Dify 提供了一个与众不同的替代方案。因为它是开源的,你可以自行托管。这带给你:

- 完整的数据主权: 你的私有数据保留在你自己的服务器上。

- 无供应商锁定: 你拥有编排层的完全控制权。

- 领域专业知识: 通过在本地优化知识库和提示词,你构建的是属于你业务独有的资产,不受公共模型通用偏见的影响。

结论

Dify 的目标很简单:让开发者专注于创新,而不是处理基础设施的繁琐工作。

通过将 AI 的后端与运维标准化,Dify 让你能在极短的时间内,从 "Hello World" 进展到功能齐全、特定领域的 AI 应用。无论你是独立开发者,还是寻求部署安全内部工具的企业,Dify 都提供了让你的 AI 变得实用、精准且可靠的架构。

准备好开始构建了吗?立即 在 Zeabur 上部署 Dify 模板 或 注册 Zeabur 以开始你的第一个 Agent!